Si eres tan inteligente, ¿por qué no eres rico? Resulta que pueder ser sólo una casualidad.

Las personas más exitosas no son las más talentosas, solo las más afortunadas, confirma un nuevo modelo informático de creación de riqueza. Tomarlo en cuenta puede maximizar el rendimiento de muchos tipos de inversión.Emerging Technology from the arXiv

La distribución de la riqueza sigue un patrón bien conocido a veces llamado una regla de 80:20: el 80 por ciento de la riqueza es propiedad de un 20 por ciento de la población. De hecho, un informe el año pasado concluyó que solo ocho hombres tenían una riqueza total equivalente a la de los 3.800 millones de personas más pobres del mundo.

Esto parece ocurrir en todas las sociedades a todas las escalas. Es un patrón bien estudiado llamado ley de poder que surge en una amplia gama de fenómenos sociales. Pero la distribución de la riqueza se encuentra entre las más controvertidas debido a los problemas que plantea sobre la justicia y el mérito. ¿Por qué tan pocas personas tienen tanta riqueza?

La respuesta convencional es que vivimos en una meritocracia en la que las personas son recompensadas por su talento, inteligencia, esfuerzo, etc. Con el tiempo, muchas personas piensan que esto se traduce en la distribución de riqueza que observamos, aunque una buena dosis de suerte puede desempeñar un papel.

Pero hay un problema con esta idea: mientras que la distribución de la riqueza sigue una ley de poder, la distribución de las habilidades humanas generalmente sigue una distribución normal que es simétrica con respecto a un valor promedio. Por ejemplo, la inteligencia, medida por las pruebas de CI, sigue este patrón. El coeficiente intelectual promedio es de 100, pero nadie tiene un coeficiente intelectual de 1.000 o 10.000.

Lo mismo ocurre con el esfuerzo, medido por las horas trabajadas. Algunas personas trabajan más horas que el promedio y otras trabajan menos, pero nadie trabaja mil millones de veces más que nadie.

Y sin embargo, cuando se trata de las recompensas por este trabajo, algunas personas tienen miles de millones de veces más riqueza que otras personas. Además, numerosos estudios han demostrado que las personas más ricas generalmente no son las más talentosas por otras medidas.

¿Qué factores, entonces, determinan cómo los individuos se hacen ricos? ¿Podría ser que la oportunidad juegue un papel más importante de lo que nadie esperaba? ¿Y cómo pueden explotarse estos factores, cualesquiera que sean, para hacer del mundo un lugar mejor y más justo?

Hoy recibimos una respuesta gracias al trabajo de Alessandro Pluchino en la Universidad de Catania en Italia y un par de colegas. Estos muchachos han creado un modelo informático de talento humano y la forma en que las personas lo utilizan para explotar oportunidades en la vida. El modelo permite al equipo estudiar el papel del azar en este proceso.

Los resultados son algo así como una revelación. Sus simulaciones reproducen con precisión la distribución de la riqueza en el mundo real. Pero los individuos más ricos no son los más talentosos (aunque deben tener un cierto nivel de talento). Ellos son los más afortunados. Y esto tiene implicaciones significativas en la forma en que las sociedades pueden optimizar los rendimientos que obtienen por las inversiones en todo, desde empresas hasta ciencias.

El modelo de Pluchino y compañía es sencillo. Está formado por N personas, cada una con un cierto nivel de talento (habilidad, inteligencia, habilidad, etc.). Este talento se distribuye normalmente alrededor de algún nivel promedio, con alguna desviación estándar. Así que algunas personas son más talentosas que el promedio y otras lo son menos, pero nadie es más talentoso que nadie.

Este es el mismo tipo de distribución que se observa para varias habilidades humanas, o incluso características como la altura o el peso. Algunas personas son más altas o más pequeñas que el promedio, pero nadie es del tamaño de una hormiga o un rascacielos. De hecho, todos somos bastante similares.

El modelo de computadora grafica a cada individuo a lo largo de una vida laboral de 40 años. Durante este tiempo, los individuos experimentan eventos afortunados que pueden explotar para aumentar su riqueza si tienen suficiente talento.

Sin embargo, también experimentan eventos desafortunados que reducen su riqueza. Estos eventos ocurren al azar.

Al final de los 40 años, Pluchino y sus colegas clasifican a los individuos por riqueza y estudian las características de los más exitosos. También calculan la distribución de la riqueza. Luego repiten la simulación muchas veces para verificar la robustez del resultado.

Cuando el equipo clasifica a los individuos según la riqueza, la distribución es exactamente igual a la que se ve en las sociedades del mundo real. "Se respeta la regla '80 -20 ', ya que el 80 por ciento de la población posee solo el 20 por ciento del capital total, mientras que el 20 por ciento restante posee el 80 por ciento del mismo capital", informan Pluchino y compañía.

Eso puede no ser sorprendente o injusto si el 20 por ciento más rico resulta ser el más talentoso. Pero eso no es lo que pasa. Las personas más ricas no suelen ser las más talentosas o cercanas a ellas. "El éxito máximo nunca coincide con el talento máximo, y viceversa", dicen los investigadores.

Entonces, si no es el talento, ¿qué otro factor causa esta distribución desigual de la riqueza? "Nuestra simulación muestra claramente que tal factor es simplemente pura suerte", dicen Pluchino y compañía.

El equipo lo muestra clasificando a los individuos según el número de eventos afortunados y desafortunados que experimentan a lo largo de sus carreras de 40 años. "Es evidente que las personas más exitosas también son las más afortunadas", dicen. "Y los menos exitosos también son los más desafortunados".

Eso tiene implicaciones significativas para la sociedad. ¿Cuál es la estrategia más efectiva para explotar el papel que juega la suerte en el éxito?

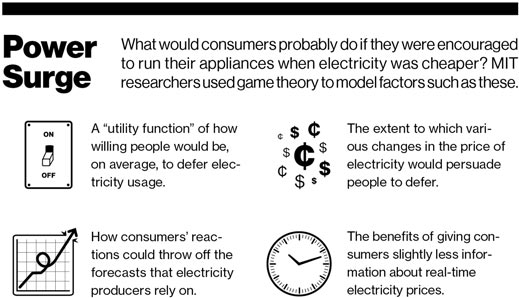

Pluchino y sus colegas estudian esto desde el punto de vista de la financiación de la investigación científica, un tema claramente cercano a sus corazones. Las agencias de financiamiento de todo el mundo están interesadas en maximizar su retorno de la inversión en el mundo científico. De hecho, el Consejo Europeo de Investigación recientemente invirtió $ 1.7 millones en un programa para estudiar la casualidad, el papel de la suerte en el descubrimiento científico, y cómo se puede explotar para mejorar los resultados de financiamiento.

Resulta que Pluchino y compañía están bien preparados para responder a esta pregunta. Utilizan su modelo para explorar diferentes tipos de modelos de financiamiento para ver cuál produce los mejores rendimientos cuando se tiene en cuenta la suerte.

El equipo estudió tres modelos, en los que la financiación de la investigación se distribuye por igual a todos los científicos; distribuido aleatoriamente a un subconjunto de científicos; o dado preferencialmente a aquellos que han tenido más éxito en el pasado. ¿Cuál de estas es la mejor estrategia?

La estrategia que ofrece los mejores rendimientos, resulta, es dividir los fondos de manera equitativa entre todos los investigadores. Y la segunda y tercera mejores estrategias involucran la distribución aleatoria al 10 o 20 por ciento de los científicos.

En estos casos, los investigadores pueden aprovechar mejor los descubrimientos casuales que hacen de vez en cuando. En retrospectiva, es obvio que el hecho de que un científico haya hecho un descubrimiento importante en el pasado no significa que sea más probable que lo haga en el futuro.

Un enfoque similar también podría aplicarse a la inversión en otros tipos de empresas, como pequeñas o grandes empresas, nuevas empresas de tecnología, educación que aumenta el talento o incluso la creación de eventos afortunados al azar.

Claramente, se necesita más trabajo aquí. ¿Qué estamos esperando?

Ref: arxiv.org/abs/1802.07068 : Talent vs. Luck: The Role of Randomness in Success and Failure